SEO Life! Мы продолжаем! Продвигаем сайт Монтессори-центра «Розовый кубик» в режиме онлайн.

Собственно, сайт готов. Конечно, его еще дорабатывают, что-то согласуется с заказчиком, но мы уже можем начинать. Начнем мы с внутренней оптимизации. Сегодня мы сделаем несколько важных вещей:

- Добавим сайт в Яндекс.Вебмастер

- Добавим сайт в Google Search Console

- Составим файл robots.txt

- Составим файл sitemap.xml

Это первые и самые главные вещи для взаимодействия сайта с поисковыми системами. Поехали!

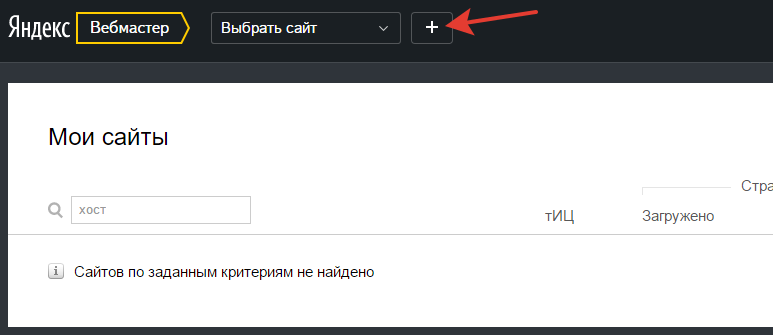

- Для чего нужно добавлять сайт в Яндекс.Вебмастер? Это необходимо делать для того, чтобы вы могли в некоторой степени управлять индексацией сайта (добавлением страниц вашего сайта в поисковую выдачу). Также здесь можно делать другие полезные вещи, о которых мы расскажем позже. Первым делом зайдем в свой аккаунт Яндекс. Если такой имеется, если нет — регистрируем аккаунт здесь. Далее заходим на сервис Яндекс.Вебмастер. И здесь, собственно, мы должны видеть наш сайт. Но если аккаунт пустой — сайтов в списке не будет (логично). Жмем добавить сайт:

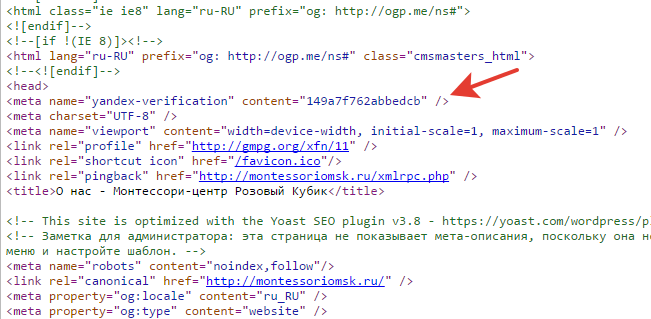

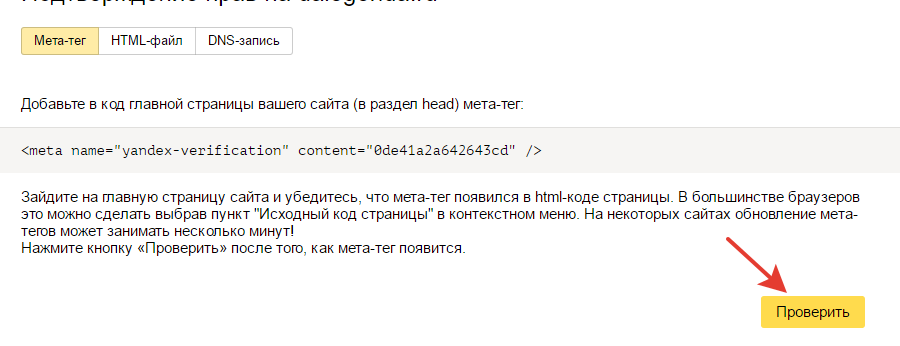

В открывшемся окне вводим адрес сайта. Далее мы видим несколько способов подтверждения. Можете выбрать любой. Для Монтессори мы использовали мета-тег, который вставили в код сайта между тегами <head>.

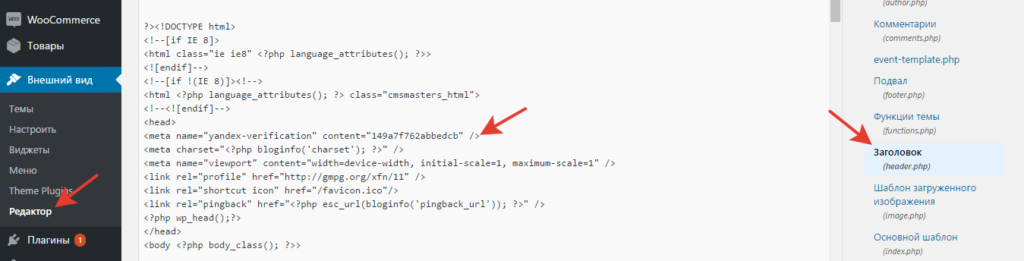

Как это сделать, если вы далеки от программирования? Конечно, можете попросить помощи у программиста. Но, на самом деле, это очень просто, если у вас есть CMS сайта — система управления контентом. Сайт Монтессори работает на WordPress. В данной системе нужно просто перейти в панели управления Внешний вид -> Редактор, найти файл header.php и вставить мета тег подтверждения Яндекс.Вебмастер в нужное место.

После в Яндекс.Вебмастер жмем кнопку «Проверить» и сайт успешно довавляется в систему.

Если сайт новый и был только недавно запущен, системе потребуется некоторое время для индексации — от нескольких дней до недели. После этого вам откроется доступ к инструментам вебмастера, которые несут большую пользу для оптимизатора. Наш сайт пока обрабатывается, поэтому двигаемся дальше.

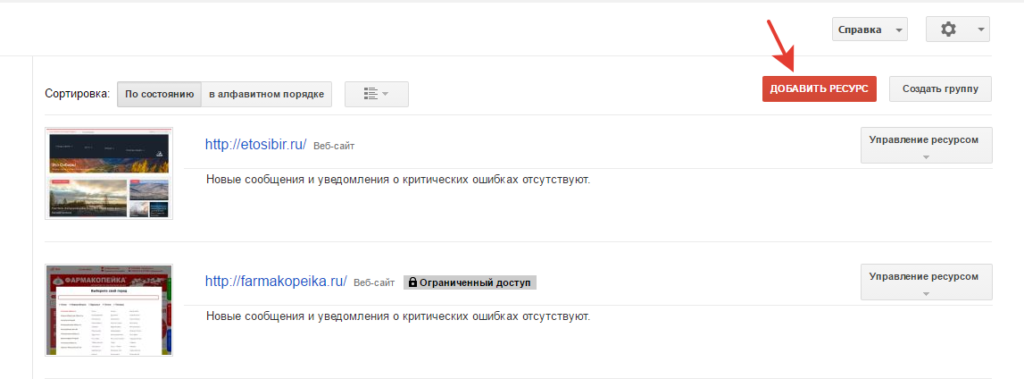

2. Добавим сайт в Google Search Console. Переходим в сервис. Конечно же, здесь также требуется аккаунт, но уже Google. Создаем его, если нет. И теперь в самом сервисе мы жмем кнопку «Добавить ресурс».

Здесь нас ожидает аналогичная процедура, как и в Яндекс. Также, если сайт новый, после подтверждения прав на управление сайтом, придется подождать некоторое время, прежде, чем в сервисе появится информация о сайте.

3. Создаем файл robots.txt. На данном этапе все зависит от CMS. Воспользовавшись поиском, вы найдете типовой файл robots.txt для вашей системы.

Что делает данный файл? Он «подсказывает» поисковым роботам, какие страницы стоит выдавать в поиске (поместить в индекс), а какие не стоит. К примеру, системные файлы, точки входа в панель администратора, страницы изображений, страницы настроек, отдельные страницы с непонятными сложениями или изображениями. Также здесь нужно закрывать от индексации страницы, которые не несут логичной и относящейся к делу информации, к примеру, такими могут быть отдельные страницы комментариев или отдельные страницы каждой новости, которые содержат совсем мало текста. В общем, поисковикам лучше запрещать индексацию таких страниц.

Вот некоторый список команд, который прописывается в файле robots.txt, для Яндекс: ссылка и для Google: ссылка.

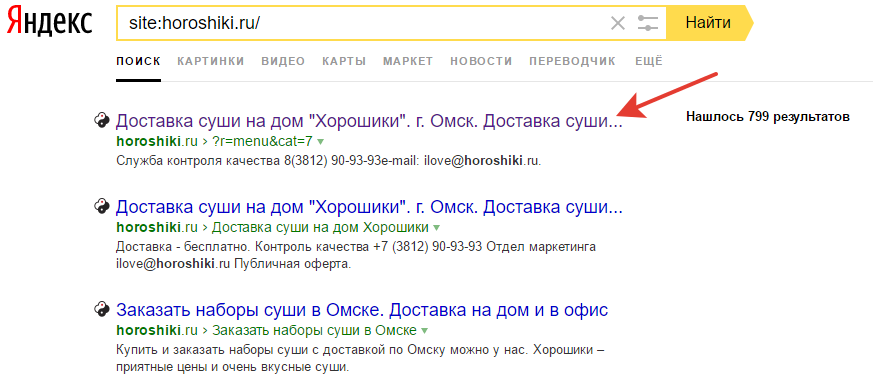

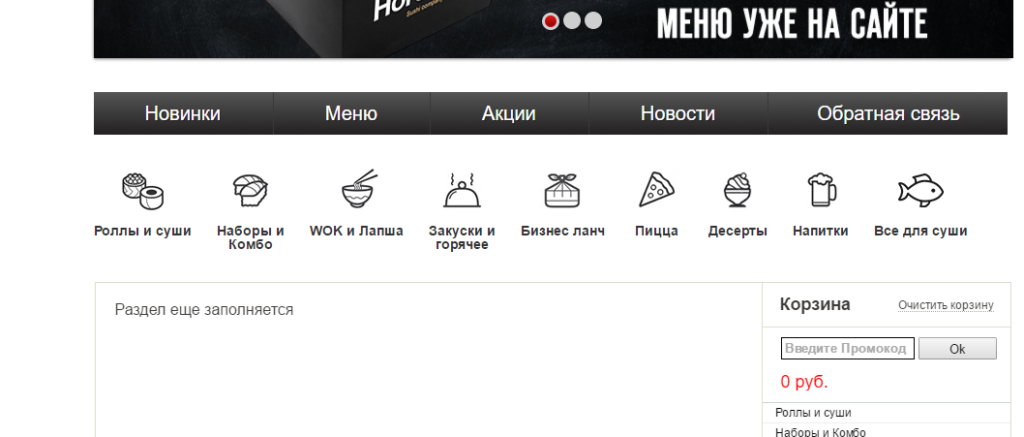

Для несложного и небольшого сайта проще сделать так: вы находите типовой файл для вашей CMS и добавляете в него те страницы, которые вы не хотите видеть в поиске или не хотите, чтобы они индексировались. Если сайт не новый, можете сами прописать адреса страниц, а также можете немного схитрить: зайти в поиск и прописать: «site: адрес вашего сайт», и поисковик выдаст все, что имеет по вашему ресурсу. Список может быть очень длинный, при добавлении типового файла robots.txt большинство «мусора» уже не попадает в поиск, но все-так, давайте посмотрим на примере какого-нибудь омского сайта, что можно закрыть от индексации. Доставка суши «Хорошики», напишем в поиске «site:horoshiki.ru» и посмотрим, что можно закрыть от индексации. Здесь мы увидим, что есть какие-то сомнительные страницы, не несущие полезной информации.

Возможно, так нужно, но если индексация какой-то отдельной страницы не требуется, один из способов — прописать запрет в robots.txt:

Disallow: /?r=menu&cat=7

Попробуйте проверить свой сайт и запретить индексацию ненужных страниц. Только это способно оказать положительное влияние на продвижение.

А для нашего нового сайта Монтессори мы составим типовой файл robots.txt для WordPress:

User-agent: *

Disallow: /admin/

Disallow: /cgi-bin/

Disallow: /wp-login.php/

Disallow: /wp-register.php/

Disallow: /wp-cron.php/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/

Disallow: /wp-content/plugins

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Disallow: /user/

Disallow: /feed/

Disallow: /search/

Disallow: /cart/

Disallow: /tag/gallery/

Disallow: /?attachment_id=1380

Disallow: /checkout/

Disallow: /my-account/

Disallow: /edit-address/

Disallow: /lost-password/

Disallow: /change-password/

Disallow: /view-order/

Disallow: /logout/

Host: montessoriomsk.ru

Sitemap: http://montessoriomsk.ru/sitemap.xml

Сейчас основная задача — не допустить индексации всякого системного «мусора», который будет сбивать с толку поисковик.

4. А теперь пришло время sitemap.xml или как еще говорят xml карты сайта. Этот файл служит как бы картой сайта для поисковых роботов, где отображаются в нужном виде все ваши страницы. Делать этот файл вручную граничит с безумием 🙂 Для всех CMS существуют плагины, которые формируют карту сайта, мы также воспользуемся плагином.

В настройках таких плагинов можно указывать, какие разделы сайта индексировать. У нас на сайте есть страницы сотрудников, их тоже будем добавлять в карту сайта. Остальные страницы по умолчанию добавлены в карту сайта.

Для WordPress посоветую хороший плагин для Sitemap: Google Sitemap XML. Позволяет изменять многие параметры, работает очень адекватно. В общем, для своего сайта мы включили в карту страницу, записи и страницы профилей. Этого достаточно. Есть такой параметр «Priority» для каждого элемента карты сайта. Он изменяется от 0 до 1. Для главной страницы определим 1, для остальных 0,6. Также есть такой параметр, как частота обновления, для главной лучше выставить «Ежедневно». Для остальных «Раз в неделю».

Вот ссылка на получившийся файл: http://montessoriomsk.ru/sitemap.xml

А мы ждем индексации поисковиками для отображения в Яндекс.Вебмастер и Google Search Console. В следующий раз мы расставим мета-теги на страницах и записях сайта и сделаем первые настройки в инструментах вебмастеров Яндекс и Google.